贝博网页登录版.他说中国汽车大模型公司将成全球第一

发布时间:2024-05-25 13:58:34 来源:ballBET贝博BB艾弗森 作者:贝博艾弗森体育网页版- 咨询热线:0754-89933008

您好!欢迎光临贝博网页登录版-ballBET贝博艾弗森体育网页版

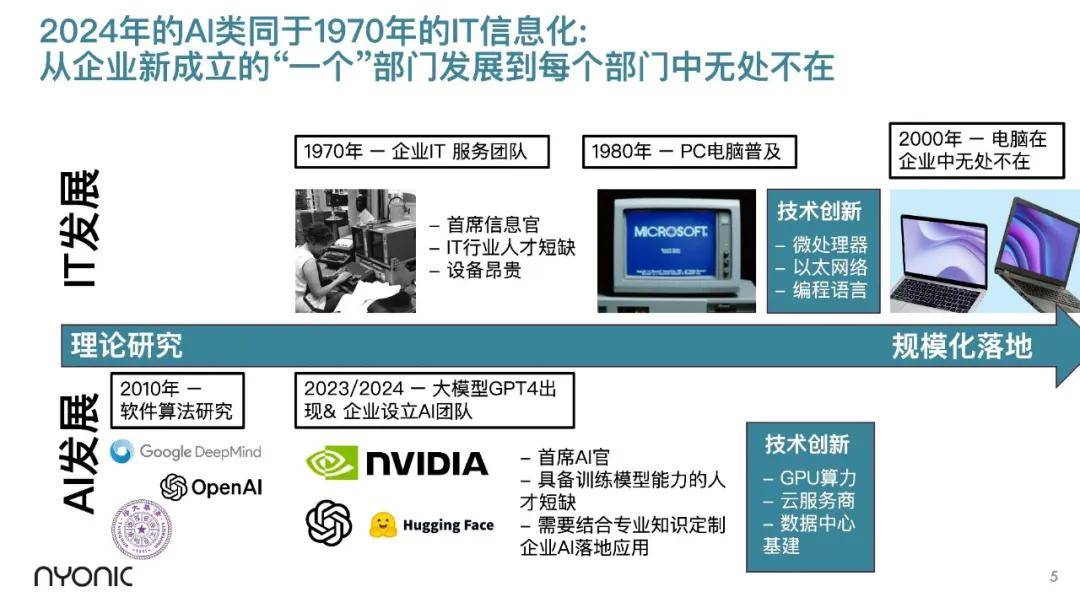

2022年开始由OpenAI推出的ChatGPT3的惊人表现迅速让人工智能成为全社会的热点。

这种热度不只是表现在场,全球资本市场真金白银的巨额投入以及英伟达作为人工智能时代核心厂商市值的飙升都宣告了一个新时代的即将来临。

轩辕之学巨浪4期学员韩东正处于这一大风口,作为NYONIC的创始人,他公司的主营业务是帮助企业建模型工厂,训练模型,赋能应用,为汽车行业链条上的企业赋能。

韩东本人从事人工智能相关工作约在20年前,当时是作为学生身份。他2004年至2008年就读德国马克思普朗克研究院计算机所,专业是计算机科学。马克思普朗克研究院计算机所是欧洲排名第一阵营的计算机科研院所。

“2012年之前深度学习是计算机领域一个没人愿意碰的东西,坚持下来的人并不多。当时没有人需要AI博士,大家其实都找不到工作。”韩东说。

2024年3月17日,轩辕之学巨浪4期第六模块“汽车营销新思维”课程的第二天下午,按既往惯例,学员进行分享,每次大概2-3人。韩东作为第一个学员进行分享。

“我是AI科班出身的从业者,二十多年前大学一年级就开始在德国人工智能研究中心做NLP的研究助理工作,也做了计算机视觉和机器学习的研究,十多年前就在ICCV上发表文章。后面经过了德国创业孵化器的熏陶叫ROCKET INTERNET,这是一家孵化了众多独角兽公司的孵化器。”

他说2020年之前,深度学习训练出来的Chatbot的水平和1960年的水平基本没有本质区别,过去六七十年一直没有什么大的变化。前几十年很少有人相信这件事能做成,觉得深度神经网络是一门玄学。但GPT3让大家第一次看到了所谓的涌现能力,之前没有训练模型做这件事情,但模型自己就会。你会发现训练出来的模型可以做无数件它没有遇到过的事情,这一直是大家梦寐以求的事情。

马强毕业于人民大学EMBA,他在智能网联汽车电子软件行业超过15年以上。他曾在东软集团任职,2015年加入中科创达。

以手机软件起家的中科创达随着2015年智能座舱概念的兴起成功进入了座舱领域,公司营收也由此进一步增长。但马强说近几年中科创达也正经历转型。他说目前操作系统厂商和芯片厂商,除了进行标准系统的开发外,也同时进入了定制化业务,这对中科创达的原有业务产生了一定影响。这是当前他们的挑战之一。

另外,主机厂的降本要求与日俱增。他说最开始做高通8155芯片时,车企一个座舱平台的研发预算大概在大几千万元,现在已降到几百万元。

2012年之前深度学习是计算机领域没人愿意碰的东西,做深度学习坚持下来的人并不多。OpenAI GPT2出来的时候效果非常糟糕,没有人把它当学术来对待,但是GPT3出来让所有人都惊呆了,大家觉得这个方向真的可以走通。这也导致现在这一领域的人才数极少,大部分被OpenAI和谷歌两家公司卷走了,基本上来讲,你很难吸引这些人回到国内的公司。

现在大家的共识是AI将重构每个国家的战略、行业、应用。我们过去这一年跟美国、跟欧洲很多这方面的专家打交道时发现,很明显AI在大国竞争当中扮演非常重要的角色。

最大的三个机会,第一个在GPU领域,大家都知道英伟达过去一年通过大模型他们非常的飞速增长,包括毛利、净利润,这些都非常的惊人。第二个大的商业机遇在云计算领域,因为所有这些AI模型对外提供服务的时候,都得在云上对外提供。第三个可以从两个角度来说,一个是行业角度,因为各行各业后面都会被AI赋能。我们日常生活当中可能用到最多的三个端侧,一个是PC电脑笔记本、第二个是手机、第三个是汽车。

中国在汽车这个场景下是一个无法忽略的市场,因为占领全球三分之一。AI比拼主要还是中国和美国之间,车的大模型这一块美国公司很难去做到全球领先,因为美国可能连相应的客户都没有,车厂也只有特斯拉一家。所以这一块我有一个信念,全球最领先的汽车行业的大模型公司肯定会来自于中国。

我们说行业大模型到底是什么意思?它不是说我们做一个行业大模型可以解决汽车行业所有的事情,而是去跟通用基础大模型进行区分。在行业大模型基础上,更多去跟汽车行业具体场景结合,在不同的环节加入额外的高质量数据得到额外的能力去解决具体的事情,就好像数字员工,有些做专业文档写作,有些做软件开发和测试。

我们自己在这一年主要做了两件事情:搭建了一个训练大模型的模型工厂,包括整个数据处理,训练和推理的基础设施,同时有能力去给各个客户或者合作伙伴输出不同的行业模型或场景模型。

整个模型训练的工程过程,一开始有非常大量的数据,很多是公开数据,如果说训练一些行业模型,场景模型可能会有些企业数据。公开数据会在模型工厂里有整个数据的预处理,数据混合(data mix),ETL的管道,同时不断的有一个评估的过程,再去做训练。但是因为数据量太大了,深度神经网络又不是可解释的东西,所以就造成了大模型特别难训练,因为模型参数太多,数据量太多,单纯训练就很难,把那么多GPU连起来也很难,高算力的GPU包括A100或者H100包括昇腾等,这些都是半成品,现在还处在不断的在往前迭代的产品,问题非常非常多。

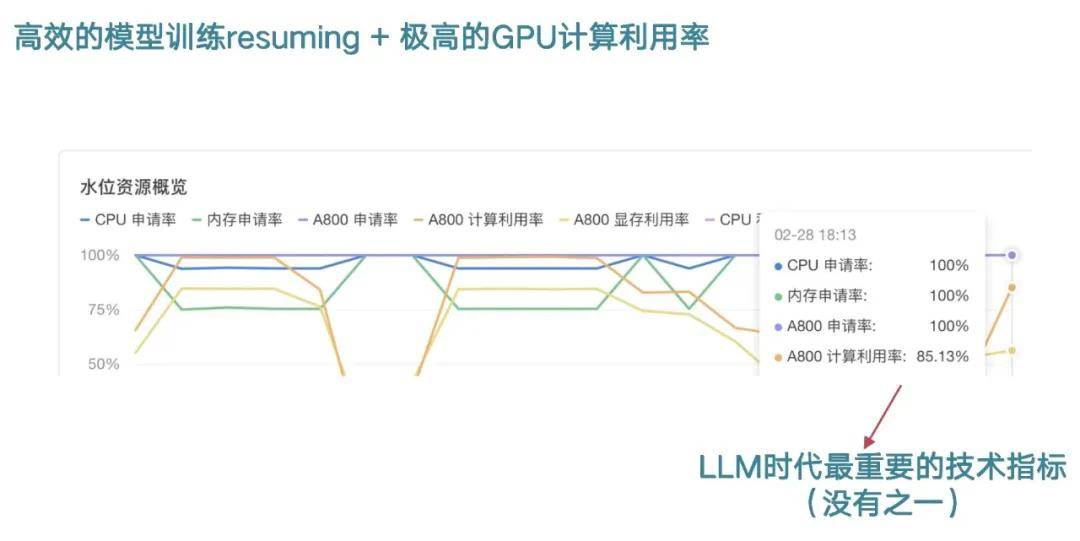

我这边举个核心挑战的例子。超大规模的数据处理,GPU算力利用率。算力的利用率这边有一个对标的数字就是GPT4大概在2万多个A100的进行了90-100天的训练,算力利用率只有33%,就是说这么长时间很多机器并不是真正在做训练的。整体的花费,跑一次大概在6千万美金,跑一次是什么概念?这是成功的一次,但在之前至少做的实验数目整个成本可能是10倍-50倍之间。GPT4也比较贵,它本身是万亿参数的模型,本身就非常复杂难收敛,包括GPU太多时候要保证它的稳定性也更难。

在超大规模数据处理这一块,我们在基础设施上面希望能解决一些问题,让我们后续训练高效。基座模型基础上如果进行重新的预训练或者说继续训练,我们要保证数据加进去的时候不是从头开始,而是可以继续收敛我的loss曲线,不同的功能点、不同的指标能够同时不断的去收敛,就这件事情非常难做到。

但是做到之后,取得的效果有点像可能训练第一个模型花了100块,再训练第二个模型在处理数据的时候可能只需要花1块钱,但是如果没有这个东西,可能第一个模型花100块,第二个模型还是花100块,再往下整个从经济学上或者跟服务客户的时候这个账就算不过来了。

第二个是GPU利用率,包括模型训练中断怎么再接起来?一开始训练中断,解决问题经常要解决一两天甚至两三天才能让它继续训练,但现在我们已经把这个时间从一两天、两三天降到一到两分钟,这对于整个的成本改变非常大。

在整个GPU的计算利用率上面,我们刚才也看到包括OpenAI当时做GPT4,整个计算利用率30%多,万卡集群上目前为止也没有人可以做到更好。我们目前数百张卡的集群,计算利用率达到85%,远远超过业界平均水平,这个到最后就是非常大的影响成本的指标,因为这个行业需要不断的去训练各种参数规模的模型。

我们也摸索了和客户共同创新的方式,一般会先做可行性研究包括POC,然后具体场景的智能化改造,这个市场就很大了,各个公司都有AI赋能的场景。

我们有几个具体的客户,这是帮助一家国际的Tier1来解决设备维修问题,它有报警之后会自动出来维修的建议。过去维修的建议它的准确率是比较低,所以无法真正让工人很有效的把它使用起来,但我们通过大模型,很快的帮它把故障识别率做到90%,而过去只有10%,这个工具就变得真正切实可用了。

质量标准问答也是类似的Q&A系统,在做这件事情的时候,企业内部有非常大量的数据,但这些大量的数据很多都是非结构化的、分散的,散落在各个地方,过去并没有很好的方法能够把这些文档、过去的知识、数据引入到AI模型当中来。但现在大模型的能力,它不需要标注这些训练的数据,你只要能够把它一起收集起来,把它放进来,做一定的预处理和数据混合,我们自己还只是语言模型,所以我们在做视觉训练时,包括流程图我们用其他多模态模型的接口,转化为文本来使用,通过大模型真正可以把它的知识很好的联系起来,让助手从过去10%的准确率提高到了80%。

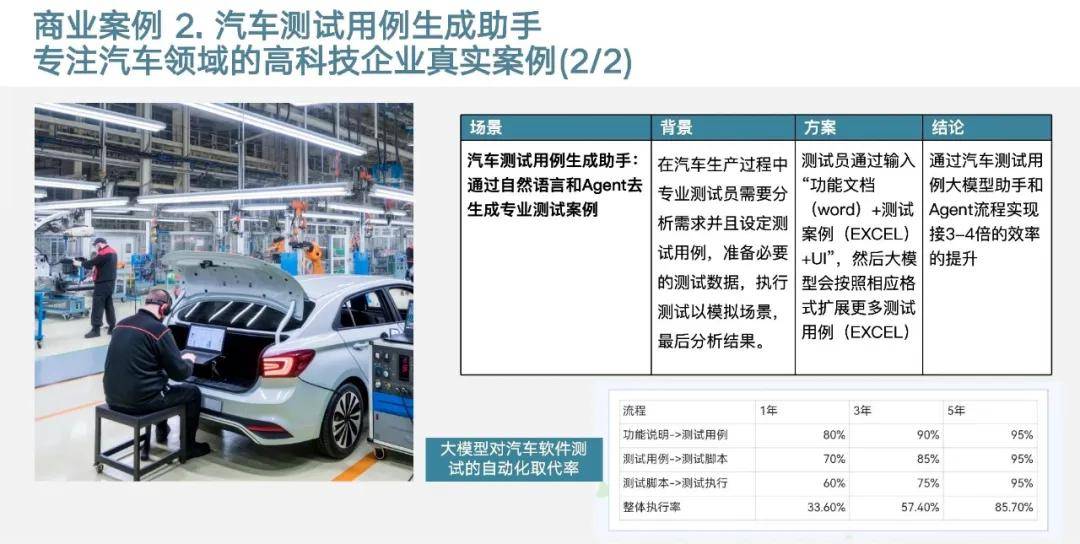

第二个在汽车软件测试这一块,我们知道软件测试它有很多工具,但中途也会有很多人类专家介入的环节,人类专家介入的是什么?就是在理解人类的语言,然后做逻辑推理、分拆、计划下一步应该怎么做然后再去执行。

牵扯到这些语言的理解都是可以用大模型来做的,我们这边是用大模型和Agent把整个专业的测试样例去做自动化的生成,光在这一步大概有三、四倍的提升。整个这一块我们会发现只要过去有人类专家介入的工作流,或多或少在未来都可以用AI+Agent去把它部分取代甚至于完全的取代,它就形成端到端自动化,一旦端到端自动化就解决了非常多的问题,成本也可以大幅度降低。

我们差不多20个人左右做了这件事情。我们经常说到一个观点,这个行业在初期不配招太年轻的工程师,因为我们每个人的成本确实很高,更贵的是你要给他们配算力,这方面如果你用错一个人,会浪费很多钱,浪费掉的是算力。

我们公司是2008年成立的,公司创业时是基于Linux手机设。